Moncef Hidane a effectué un post-doctorat de 2013 à 2014 dans le cadre du Labex CPU. Il a au préalable effectué une thèse de doctorat au laboratoire GREYC à Caen, sur la problématique de décompositions de signaux sur graphes. Il est aujourd’hui enseignant chercheur à l’INSA Centre Val de Loire.

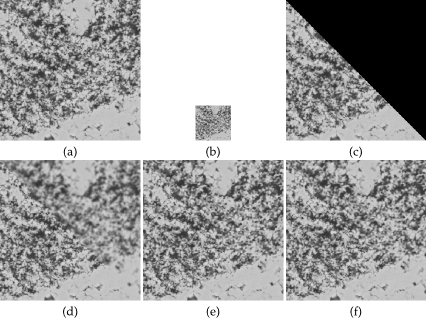

Le sujet du post-doc porte sur la reconstruction d’images 3D à partir d’une acquisition complète en basse résolution et d’une acquisition partielle en très haute résolution. Il s’agit donc d’un problème inverse de super-résolution.

Le modèle adopté pour l’acquisition basse résolution est celui d’une convolution suivie d’un opérateur de sous-échantillonage spatial ou spectral. Dans un premier temps, la réponse impulsionnelle du capteur est supposée connue. Un bruit blanc additif est intégré au modèle.

Le modèle adopté pour l’acquisition haute résolution est celui d’une occlusion dont le support est connue. Un bruit blanc additif est également intégré au modèle.

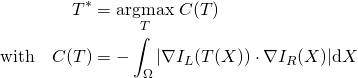

La première piste suivie est celle d’une régularisation à l’aide d’un a priori de variation totale isotrope. Deux versions sont envisagées : d’une part avec des contraintes d’inégalité, d’autre part avec des contraintes d’égalité. Dans ce cadre, une partie importante du travail concerne la minimisation des critères dans chaque cas. Du fait de la non différentiabilité de la mesure variation totale, des algorithmes issues de l’optimisation convexe non lisse sont considérés. Le but est de pouvoir disposer d’algorithmes rapides et robustes pour le calcul des solutions.

La deuxième piste suivie est un régularisation à l’aide d’un opérateur non local. L’idée est tirer partie à la fois du volume basse résolution et des images haute résolution pour construire un a priori de régularisation de type variation totale non locale.

La figure suivante illustre la problématique ainsi que les résultats obtenus avec les deux approches précédentes.